La inteligencia es un concepto complicado de definir incluso ahora, y eso que estamos inmersos en un tiempo en el que la palabra de moda es IA o Inteligencia Artificial. El concepto de Inteligencia Artificial, con todo, es relativamente nuevo (según se mire). Concretamente, la IA computacional data de los años 50 del siglo pasado, cuando un reducido número de profesionales de distintas materias centraron su atención en el incipiente mundo de los ordenadores y su potencial capacidad para exhibir un comportamiento inteligente.

Entre esos profesionales estaban Marvin Minsky, Claude Shannon, Alan Turing, Nathaniel Rochester, Roger Penrose o John McCarthy. El carácter ecléctico de este grupo es notorio y, sin ir más lejos, Marvin Minsky, uno de los padres de la Inteligencia Artificial, se graduó en Artes por la Universidad de Harvard, aunque también adquirió conocimientos en diversas disciplinas técnicas y se graduó en Matemáticas. Y, todo sea dicho, también era un buen pianista.

Shannon era matemático, ingeniero eléctrico y criptógrafo; Turing, matemático, experto en lógica, criptoanalista, filósofo y biólogo teórico; McCarthy, científico cognitivo; Penrose, matemático, filósofo y físico. Todos ellos convivieron bajo el paraguas de la incipiente ciencia de computadores, como parte de un movimiento recién salido del cascarón de empresas como IBM o Cray.

No es casualidad que en la década de los 50 del siglo XX se sentaran las bases tecnológicas de los primeros superordenadores con transistores a base de válvulas. El transistor de silicio como tal data de 1947, por lo que tenemos una concentración de innovaciones que hicieron que esos expertos en materias tan diferentes se planteasen la posibilidad de crear inteligencia a partir de máquinas artificiales.

Una posibilidad que incluso calaría en la cultura popular, que desde muy pronto identificó los procesadores de los ordenadores con «el cerebro» de los mismos. Esta analogía es una de las pruebas más evidentes de la identificación de los ordenadores con entidades potencialmente inteligentes.

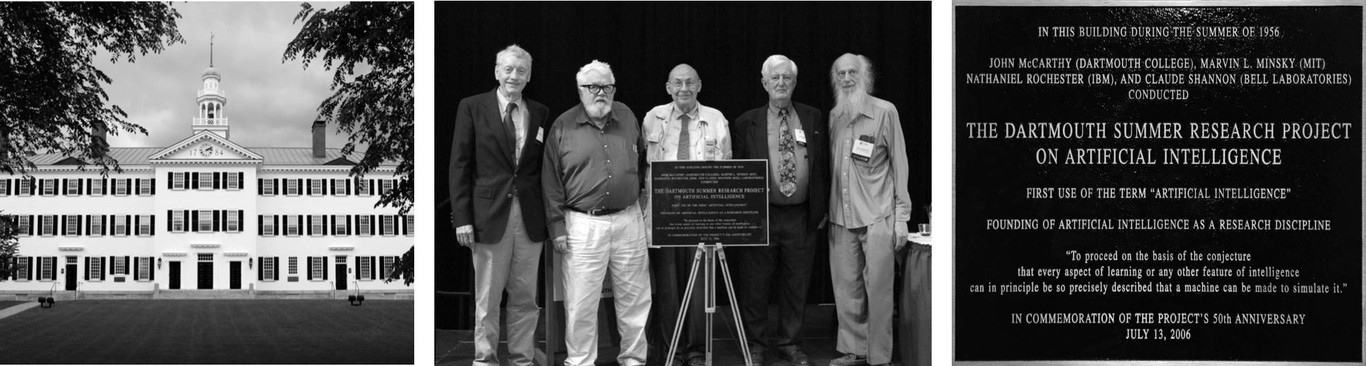

El congreso de Dartmouth

En 1956, los diferentes nombres propios involucrados en hacer que las máquinas se comportasen («pensasen») como personas, se organizaron para organizar un evento centrado en estos aspectos. Y así, de un modo especial John McCarthy y Marvin Minsky, congregaron a diferentes profesionales en un evento de ocho semanas sobre la materia. De hecho, el término de Inteligencia Artificial fue acuñado por John McCarthy en 1955 para diferenciar este campo de otros como el de los autómatas o el de la cibernética.

La conferencia de Dartmouth (Hanover, New Hampshire, EEUU) se desarrolló durante el verano de 1956 sobre la premisa de que cualquier aspecto del aprendizaje o cualquier otro rasgo inteligente puede ser descrito con tanta precisión que una máquina podría simularlo. Aspectos como el lenguaje natural y su procesamiento, las redes neuronales o la teoría de la computación fueron tratados en los dos meses del curso.

En total asistieron veinte de los más afamados y brillantes profesionales de la época, incluyendo a John Nash (el persoaje que inspiró la película “Una Mente Maravillosa”) o Allen Newell. Si John McCarthy fue el que dio nombre a la IA, Marvin Minsky puede presumir de ser el creador de la primera red neuronal digital de la historia. Fue en 1951, para experimentar con la noción de aprendizaje máquina o Machine Learning, otro término de absoluta actualidad en nuestros días.

Y todo ello sobre el precedente de Alan Turing, que trabajó sobre la teoría de la computación publicando un trabajo en 1936 que supondría el desarrollo posterior de toda la ciencia computacional. Y sobre el de Claude Shannon, que modeló la cantidad de información que transportan las señales, allá en 1950.

El MIT, cuna de la IA

En 1959, Minsky y McCarthy fundaron el MIT Computer Science and Artificial Intelligence Laboratory, que sigue existiendo y funcionando en la actualidad. Minsky se quedó trabajando como profesor en el MIT hasta su muerte en enero de 2016.

De todos modos, en los comienzos de la IA, se pecó de un excesivo optimismo que condujo a una “época oscura” entre el año 1974 y 1980. Las partidas presupuestarias que se asignaron a los primeros proyectos no dieron los frutos esperados y se dejaron de financiar iniciativas en este campo. El desánimo cundió entre algunos profesionales. En parte, el responsable fue el propio Minsky y su libro Perceptrons, que cuestionaba la validez de los métodos desarrollados hasta ese momento (1969).

Después habría varios momentos de recuperación del interés, como en la década de los 80, pero en forma de los llamados sistemas expertos. Más que inteligencia artificial, se trataba de un conjunto de datos y algoritmos capaces de extraer información a partir de los datos en materias concretas. De todos modos, eran caros de mantener y se basaban en reglas del tipo “if… then”, en las que el conocimiento estaba implícito y no se derivaba de “aprendizaje”. Es decir, un sistema experto necesita de un conocimiento previo, lo cual es radicalmente distinto al aprendizaje usando, por ejemplo, redes neuronales.

En 1989, los primeros resultados victoriosos en ajedrez por parte de “máquinas” como Deep Thought, que ganaron el campeonato nacional de ajedrez, abrieron el camino para Deep Blue, que ganó a Kasparov en 1996. Sin embargo, estos éxitos se quedaron relativamente olvidados hasta la llegada de la nueva época dorada de la IA en la que estamos inmersos, con proyectos como AlphaGo o teléfonos inteligentes como el Huawei P20 Pro. Entre otras razones, ese olvido se debía a las limitaciones del hardware y por los métodos empleados en la programación de Deep Blue, con una importante carga de conocimiento previo del ajedrez, más que como resultado de un aprendizaje automatizado como sucede ahora.

Desde principios del Siglo XXI, el interés por la IA se ha recuperado. Los progresos en el hardware, la adopción de la computación en la nube y fenómenos como el Big Data han hecho posible que se retomen proyectos que se habían dejado de lado en su día, como el del reconocimiento y procesamiento del lenguaje natural. Sobre todo, porque ya se cuenta con la capacidad de procesamiento necesaria para retomar el trabajo con las redes neuronales, capaces de aprender a través del entrenamiento con ingentes cantidades de datos que, a día de hoy, están disponibles de forma generalizada.

La IA, inspirada en la biología

La IA no es realmente un “invento” asociado exclusivamente a la ciencia computacional. Ya los filósofos griegos trataron de sistematizar la inteligencia, en cierto modo, a través de lógica proposicional o de técnicas de argumentación e inducción. Se trataba de métodos para sistematizar la forma de pensar y actuar, no tanto con el fin de que una entidad artificial se comporte como un humano, como con el fin de que una entidad biológica se comporte de un modo humano.

Con los descubrimientos sobre el funcionamiento del cerebro o el papel de las neuronas en la función cerebral, se empezó a tratar de imitar el funcionamiento de las neuronas en el mundo de la electrónica, usando lógica y estadística para modelar el comportamiento de estas redes neuronales.

De hecho, el propio Marvin Minsky reconoce que su trabajo está inspirado, a su vez, en el de un biofísico matemático llamado Nicolas Rashevsky, que ya en 1930 desarrolló el primer modelo teórico de redes neuronales, que luego sería retomado por los “padres” de la IA moderna en su versión computacional.

HAL sigue sin ser posible

Con todo, a pesar de estas décadas de desarrollo de la IA, HAL 9000, el ordenador inteligente de 2001 Una Odisea en el Espacio, sigue sin ser realizable hoy en día. Precisamente, Marvin Minsky fue el asesor técnico en la película homónima, encargado de que la recreación de HAL tanto en el film como en la novela fuera lo más realista posible en la parte de la IA.

HAL, como la película, data de 1968, cuando Arthur C. Clarke y Stanley Kubrick, a partir de un relato corto de Clarke titulado “The Sentinel” escrito en 1951, desarrollaron la idea de la película y novela «2001: Una Odisea en el Espacio». Y Marvin Minsky fue la persona que ayudó a dotar de credibilidad a la IA de la película.

Posiblemente, la idea de Minsky era la de asesorar al equipo y a Clarke de modo que HAL fuese capaz de superar el test de Turing. Este test es una forma de medir la capacidad de una entidad artificial para mostrar un comportamiento inteligente equivalente o imposible de diferenciar del de un humano.

Pero hoy en día, ni siquiera la más reciente demostración de Google Duplex, la IA que supuestamente es capaz de realizar llamadas de teléfono y hablar con humanos, sería capaz de pasar este test. Por lo visto, la espectacular demostración en Google IO habría sido “apañada” lo suficiente como para desvirtuar el propósito de la misma: escenificar una IA autónoma y no diferenciable de un humano.

Juego de acrónimos: IA, ML y DL

Llegados a este punto, podemos pararnos a diferenciar tres términos que generalmente se confunden. La Inteligencia Artificial (IA) es el paraguas general bajo el que se desarrollan los intentos por parte de los seres humanos de hacer que una entidad artificial, sea una máquina o un robot, se comporte de un modo inteligente. Los ordenadores son la máquina o entidad artificial perfecta para ello, por supuesto, y los avances en la potencia de cálculo de los chips son la base del estado de la IA en el momento actual.

Posiblemente, la idea de Minsky era la de asesorar al equipo y a Clarke de modo que HAL fuese capaz de superar el test de Turing. Este test es una forma de medir la capacidad de una entidad artificial para mostrar un comportamiento inteligente equivalente o imposible de diferenciar del de un humano.

Pero hoy en día, ni siquiera la más reciente demostración de Google Duplex, la IA que supuestamente es capaz de realizar llamadas de teléfono y hablar con humanos, sería capaz de pasar este test. Por lo visto, la espectacular demostración en Google IO habría sido “apañada” lo suficiente como para desvirtuar el propósito de la misma: escenificar una IA autónoma y no diferenciable de un humano.

Juego de acrónimos: IA, ML y DL

Llegados a este punto, podemos pararnos a diferenciar tres términos que generalmente se confunden. La Inteligencia Artificial (IA) es el paraguas general bajo el que se desarrollan los intentos por parte de los seres humanos de hacer que una entidad artificial, sea una máquina o un robot, se comporte de un modo inteligente. Los ordenadores son la máquina o entidad artificial perfecta para ello, por supuesto, y los avances en la potencia de cálculo de los chips son la base del estado de la IA en el momento actual.

De momento, prácticamente todos los avances en IA que nos sorprenden estos últimos tiempos, son logrados usando ML y DL sobre un hardware cada vez más eficiente y usando ingentes cantidades de datos para «entrenar» a las redes neuronales. Incluso Google y Microsoft han desarrollado sus propios módulos computacionales basados en chips diseñados de forma específica para ML, muy diferentes a los que conocemos de Intel o AMD. NVIDIA, por su parte, ha usado sus tarjetas gráficas para procesamiento de IA. Y, de momento, solo estamos en los albores de lo que se puede conseguir.

Mismos conceptos, diferente tecnología

Con todo, merece la pena recordar que lo que estamos viviendo hoy no es más que la recuperación de los conceptos planteados hace décadas por los padres de la IA, desarrollados en la década de los 50 del siglo pasado. Los retos que se plantearon entonces (y no se superaron) son los que se están abordando ahora con bastante éxito. En su día, los pioneros de la IA vieron cómo la tecnología no estaba a la altura, pero parece que ahora sí está a un nivel suficiente como para empezar a pensar que las máquinas podrán comportarse de un modo indistinguible de un humano.

Los éxitos tales como AlphaGo de Google y DeepMind (DeepMind fue adquirida por Google) son posibles gracias a Machine Learning. Su facilidad para batir a los maestros de Go ha sido noticia en las portadas de los medios de todo el mundo. Con todo, no estamos aún ante una IA ideal. Es un sistema experto, que ha aprendido por sí mismo sin reglas “If.. then”. Pero un sistema experto únicamente en esa materia. Las redes neuronales empleadas estaban «tuneadas» para que identificasen los elementos del juego, pero este y no otro.

IBM ganó el concurso “Jeopardy” en su día en EEUU contra concursantes humanos, pero, a pesar de ello, algunas respuestas eran propias de niños de tres años y totalmente absurdas. Las reglas «If… then» y algoritmos clasificatorios no siempre funcionaban bien.

Pero ahora tenemos una tecnología bastante más avanzada que en el pasado, e incluso ya hay hardware específico para integrarse en los smartphones, como la NPU (Neural Processing Unit) del procesador Kirin 970 de los Huawei Mate 10 o Huawei P20 y P20 Pro. Las redes neuronales se entrenan en la nube pero se «cargan» en los dispositivos para acelerar tareas relacionadas con el reconocimiento de voz o de imágenes.

La Inteligencia Artificial (computacional) está en aún en su infancia. Pero se ha avanzado más en los últimos años que en las décadas precedentes. Y estamos cerca de conseguir un HAL 9000 en la vida real, al asentarse las bases tecnológicas para democratizar campos como Machine Learning usando métodos como el aprendizaje profundo (DL) sobre redes neuronales.

Pero hablamos de IA computacional. De momento es muy atrevido asociar IA con pensamiento en el sentido humano. Los sistemas de IA aprenden sin un conocimiento previo (IF…THEN) a través del entrenamiento exhaustivo usando grandes cantidades de datos, pero la intención previa sigue siendo patrimonio de los programadores. Por lo menos por el momento.

Imágenes / Research Gate / Avata Intelligence / MIT / HAL 9000 Wikipedia / Deep Blue Wikipedia / Project Brainwave Microsoft