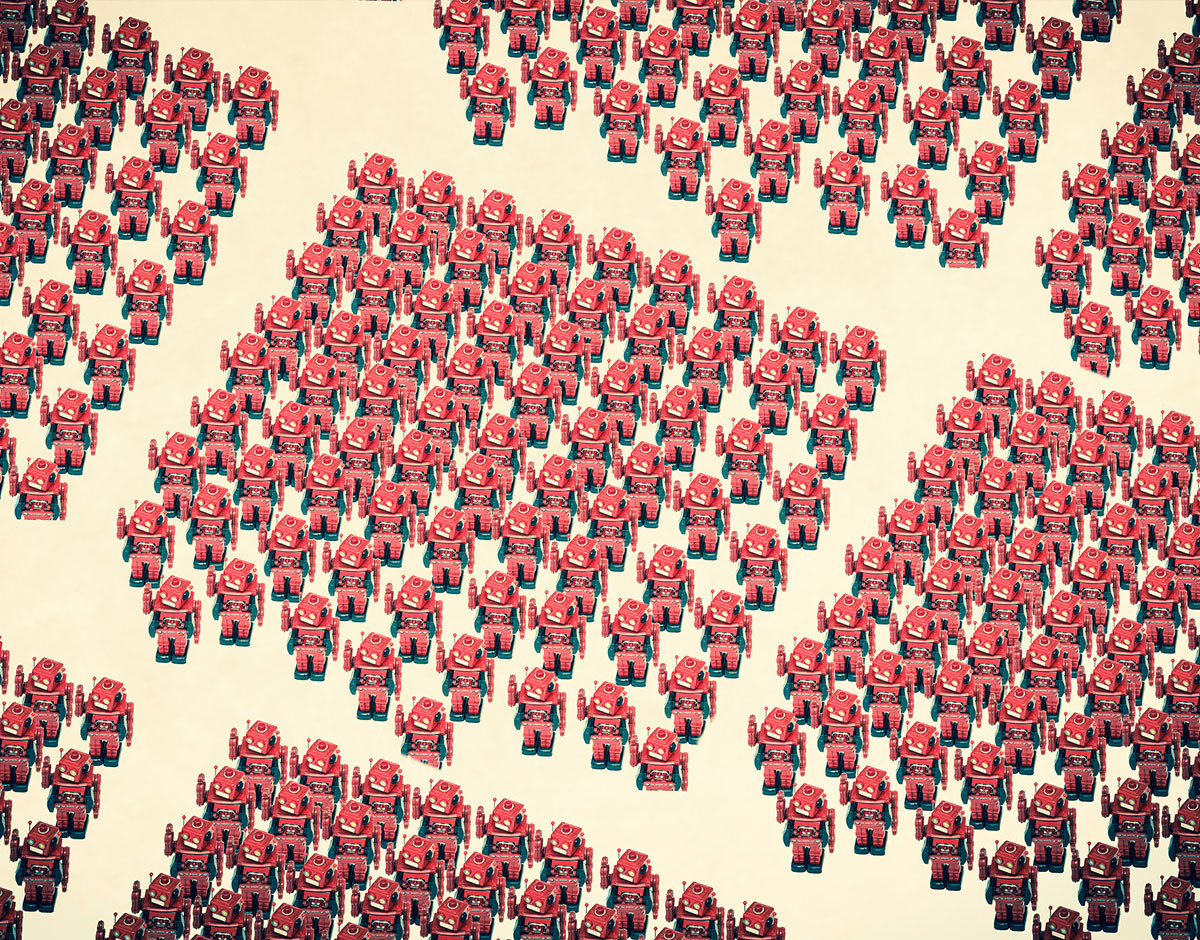

La inteligencia artificial es uno de los campos con más futuro de la ciencia y la tecnología. Como la electricidad en su momento, en unos años estará presente en todos los ámbitos de la sociedad. Sin embargo, el acceso a la misma no es heterogéneo, y esto genera grandes sesgos en sus decisiones.

El informe ‘Discriminating systems: gender, race and power in AI’, recién presentado por la Universidad de Nueva York y el AI Now Institute, estudia cómo podemos construir una inteligencia artificial más heterogénea y sin sesgos. Una tarea que no será fácil pero para la que ya tenemos mapa de ruta.

¿De dónde vienen los sesgos de las máquinas? Guardar y salir

Supongamos que un grupo de ingenieros informáticos localizan un problema y deciden utilizar inteligencia artificial para solucionarlo. Tras meses de investigaciones y desarrollos dan con un producto viable, y este llega al mercado. Hoy sabemos que los factores personales de cada uno de ellos, y especialmente sus sesgos subconscientes, han afectado al resultado final.

Por ejemplo, se ha dado el caso de que sistemas de visión artificial no reconozcan rostros diferentes a los asiáticos porque el software se entrenó con ellos a medida que lo diseñaban. Otro caso importante ocurrió en Nueva York, cuando los prejuicios de los diferentes agentes de la policía se colaron en la identificación de sospechosos. Inconscientes, pero prejuicios.

A menor heterogeneidad en los programadores, más sesgo tendrán las máquinas. Hoy tenemos la capacidad de crear gracias a la tecnología una sociedad más justa, pero para ello necesitamos unas bases de programación más equilibradas.

La brecha de género es solo una pequeña parte

Con frecuencia se habla en los medios sobre la necesidad de impulsar que las jóvenes estudien carreras técnicas. Y aunque resulta evidente que hay una marcada brecha de género y que tenemos que estudiar cómo cerrarla, esta supone solo una pequeña parte de una brecha mayor.

La brecha de género en inteligencia artificial, medida por la Universidad de Nueva York, nos refleja que el ratio de mujeres ronda el 15% en Facebook y el 10% en Google, dos de las compañías más relevantes del planeta y que más avances realizan en IA. Por cada mujer hay entre 6 y 9 varones.

La etnia es otro de los factores más importante. Se estima que solo el 2,5% de los trabajadores de Google son negros y que Facebook y Microsoft suben tan solo al 4%. Aunque el color de la piel sea la forma más directa de medir esta inclusión, y arriba hemos visto el ejemplo de la visión artificial mal entrenada, las consecuencias de no contar con un ambiente más heterogéneo son más graves de las que tenemos en mente.

De hecho, que una cámara reconozca o no un rostro según la etnia solo depende de incluir más fotografías en la base de datos. Este es un problema que sabemos corregir de forma más o menos sencilla. Sin embargo, ¿cómo incluyo la cultura de una parte del mundo cuando esta no está representada? Esto es mucho más costoso, e imposible en muchos casos.

¿Cuánta gente hace falta para diseñar una silla?

La cultura puede ser algo quizá demasiado etéreo. Pero existe un ejemplo muy acertado para visualizar el problema de la inteligencia artificial en un ámbito que todos conocemos: las sillas. Imaginemos que se encarga fabricar una silla a un conjunto de personas particularmente altas. Como resultado de haberse usado a sí mismos como “medida universal”, se decantan por una silla elevada.

Miran alrededor y llegan a la conclusión (aparentemente correcta pero sesgada) de que las sillas altas son la mejor solución al problema de dónde sentarse. Sin embargo, como en el equipo no había nadie con una estatura media o baja, no han caído en la cuenta de las dificultades que plantea su diseño.

Y así funciona hoy la inteligencia artificial. Si el software que usan miles de millones de personas en el mundo lo construye una pequeña élite de personas, resulta evidente que la gran mayoría no está representada en cómo se genera la tecnología o en su impacto posterior.

La inteligencia artificial la hace gente con estudios

“Élite” es una palabra muy presente en el informe ‘Discriminating systems’. De hecho, más allá de la cultura, etnia, género, edad, credo o cualquier otro parámetro a tener en cuenta, aquel con el que más sesgo hay es con el poder económico de quien programa la tecnología. El estatus social.

Ahora mismo, las redes neuronales se están democratizando y el uso de la inteligencia artificial empieza a permear en la sociedad. Muchos de nosotros hacemos uso de dispositivos como asistentes inteligentes con IA u otros que hacen uso de la inteligencia artificial para realizar las mejores fotografías, como ocurre con el Huawei P30 Pro.

Sin embargo, ¿cuántos de nosotros programamos? Ya hay tutoriales sobre cómo programar IA, pero ocurre que hay una brecha muy marcada en cuanto a nivel de ingresos e inteligencia artificial: quien la programa generalmente no suele tener apuros económicos.

Esto es un punto muy importante porque quien diseña la IA que usaremos en el futuro no tiene en cuenta —a nivel consciente o inconsciente— que quien la utilice puede tener problemas de dinero o una situación económica desfavorable. Mientras programa, no está pensando en esta posibilidad, porque no la experimenta. Queda fuera de la ecuación.

Hacer más atractiva la programación para las mujeres, abrir más universidades en lugares del mundo con etnias infrarrepresentadas o permitir que generaciones más avanzadas formen parte del proceso de creación de tecnología, son solo primeros pasos.

Filosofía y política para las máquinas

En abril de 2019, La Fundación Cotec presentó junto al estudio Why Maps un interesante vídeo sobre el futuro del empleo. Inteligencia artificial y empleo están muy relacionados, y ambos a su vez con la política. Por fortuna, la robotización es aún un tema no politizado y abierto a debate. Aunque no sabemos qué nos espera en los años venideros, sabemos que habrá cambios de importancia.

Si el vídeo resulta relevante es porque características como la creatividad, el pensamiento crítico o la complementariedad serán habilidades muy demandadas. Esta complementariedad es la habilidad de trabajar con personas con las que, en principio, hay una gran diferencia.

Cerca del 90% del personal que trabaja con IA tiene una situación económica acomodada. Suelen ser ingenieros informáticos o profesionales con estudios similares. Distan mucho de ser una muestra representativa de la sociedad y, al igual que ocurre con la edad, la cultura o el género, necesitamos más divergencia y heterogeneidad en las profesiones.

Como ha comentado Adela Cortina, catedrática de ética de la universidad de Valencia, ”se piensa mejor con otros” porque “la inteligencia es colectiva”. A finales de 2018 la Comisión Europea publicó su borrador con las guías éticas para la inteligencia artificial, lo que facilita que otras profesiones como la filosofía entren a formar parte del proceso de construcción de la IA.

Esperemos que en el futuro las diferentes brechas, con foco en la cultura y el poder económico, se cierren para construir entre todos una inteligencia artificial en la que nos veamos representados.

Imágenes | iStock/davincidig, iStock/davincidig, iStock/Orla, iStock/Tero Vesalainen